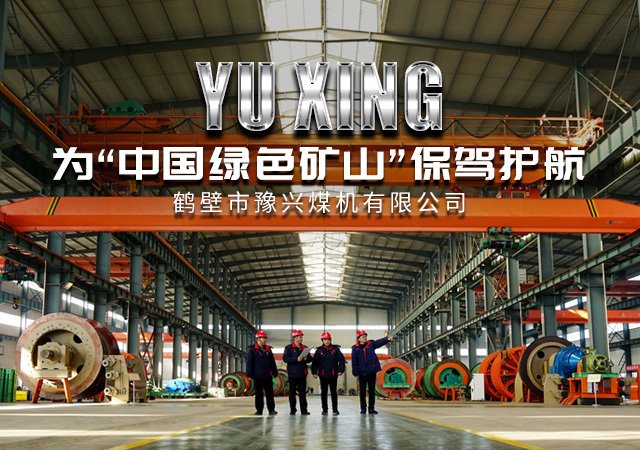

公司创立

注册资金

公司占地面积

7大产品体系

为您提供可靠的矿井提升设备

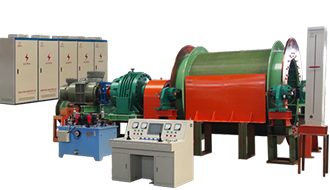

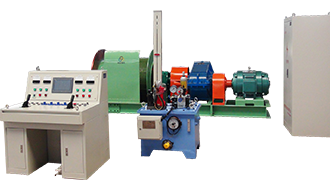

豫兴专注制造大型矿山提升设备,电器成套自动化控制系统

· 多绳摩擦式提升机

· 落地式

· 井塔式

· 单绳缠绕提升机

· JK型单绳缠绕提升机

· 2JK型单绳缠绕提升机

· JKB(隔爆)型单绳缠绕提升机

· 2JKB(隔爆)型单绳缠绕提升机

· 矿用提升绞车

· JTP型矿用提升绞车

· 2JTP型矿用提升绞车

· JTPB(隔爆)型矿用提升绞车

· 2JTPB(隔爆)型矿用提升绞车

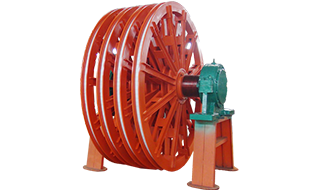

· 天轮 · 塑衬

· 深度指示器 · 润滑站

· 液压系统系列 · 液压站

· 盘形制动器配件

· 配套提升机变频电控装置

· 配套提升机隔爆型变频电控装置

· 智能闸监测系统

· 数控绳槽车削装置

始建于1988 成立于2003

免费送彩金官方网站

Hebi Yuxing Coal Machinery Co., Ltd.

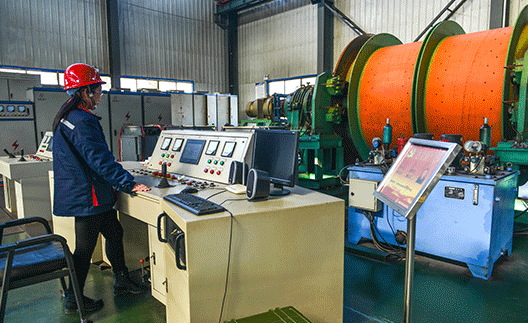

免费送彩金官方网站是以制造大型矿山提升设备,电器成套自动化控制系统为主的生产制造企业。座落于飞鹤之乡一鹤壁市山城豫兴工业园。

公司成立于1988年,拥有自营进出口经营权。健全的质量管理体系取得了IS09001质量体系认证证书,提升机及绞车系列产品获得了矿用产品安全标志证书。

公司主要生产JKM、JKMD多绳摩擦式提升机、JK、 JKB单绳缠绕式矿井提升机、JTP、JTPB矿 用提升绞车。

多年来,公司始终坚持科技兴企,以新产品开拓求发展,走产、学、研一体化的发展道路。企业联合国内外知名院校和重型矿山企业,加大技术创新力度,运用计算机辅助优化设计、优化工艺,在总结国内外矿山机械及自动化电控设计制造基础上,自主研发、制造"机电液”一体化的成套矿井提升机生产体系,生产安全、环保、节能的新产品;科技创新、自主研发为目标, 投资创建标准化车间、智能自动化电控研发中心、自动化液压站、制动器测试台和整机出厂检测中心。

以“科技创造市场,诚信铸就品牌”为核心理念,打造百年企业,服务矿山行业为己任。用品牌奉献社会、引领矿山制造业走向“国际化市场”。

行业经验丰富

企业成立于2003年,实力铸品牌

自营进出口经营权

健全的质量管理体系,自营进出口经营权

科技兴企,开拓求发展

坚持科技兴企,走产、学、研一体化发展道路

校企合作,强强联合

联合国内外院校和矿山企业,加大技术创新力

选择我们的理由

以质量求生存,以信誉求发展,靠科技更新产品。我们将以满意周到的服务真诚欢迎新老客户与我公司建立长期良好的合作关系,共谋双赢,共同发展!

新闻资讯

公司新闻、行业动态实时更新,把握前沿资讯动态!